Alerte au crawl : comment débusquer les problèmes d’exploration dans la GSC

Vous avez des questions SEO ?

Comprendre les problèmes de crawl n’est pas une mince affaire et ceux-ci peuvent insidieusement faire beaucoup de dégâts sur votre trafic organique et vos conversions. Voici les points d’attention à garder à l’esprit pour éviter la catastrophe ou diagnostiquer rapidement :

Search Console ou gros outils ?

Lorsque l’on pense à l’exploration, on se retrouve rapidement face aux outils externes comme Oncrawl ou Botify et leur coût mirobolant, pour peu que l’on gère un gros site à plusieurs centaines de milliers de pages. Si vous avez plusieurs dizaines de milliers d’euros de budget, alors oui, foncez. Si, comme beaucoup, vous n’avez pas ça sous le coude, alors vous pouvez vous rabattre sur des solutions pour petits sites comme le Log File Analyzer de Screaming Frog ou… la Google Search Console !

La GSC dispose donc d’une version simplifiée de ces gros outils, située dans Paramètres > Statistiques sur l’exploration, et offre de nombreuses fonctionalités intéressantes qui permettent souvent de débusquer de gros soucis sans avoir à débourser un rouble.

Est-ce pour autant suffisant ? Non, mais souvent faute de mieux, la plupart des référenceurs se rabattent dessus avec un succès certain.

Les points d’attention

Vous voilà maintenant dans l’espace « Statistiques sur l’exploration » de la Search Console. Les sections à regarder sont :

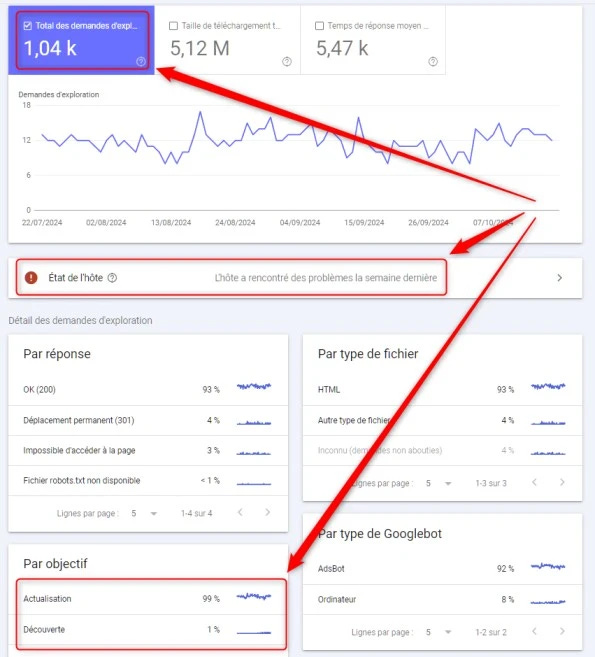

La stabilité du total des demandes d’exploration

Si l’hôte rencontre des problèmes

Le niveau d’actualisation/découverte des URLs

Total des demandes d’exploration

Le total des demandes d’exploration doit rester stable, hormis lorsque du nouveau contenu est créé. Même si une augmentation drastique peut parfois indiquer un intérêt accru de la part de Google, c’est souvent révélateur de problèmes plus profonds, liés à du contenu dupliqué par exemple.

État de l’hôte

À ignorer la plupart du temps SAUF lorsque des problèmes sont mentionnés. Des troubles de serveur par exemple y sont régulièrement mentionnés et peuvent être relayés rapidement aux équipes concernées pour une résolution rapide.

Actualisation et découverte des URLs

De manière générale, le niveau de découverte de nouvelles URLs devrait rester faible, même en cas de publication importante de nouveaux contenus.

Si le niveau de découverte dépasse 10-20%, alors il est fort probable qu’un nombre considérable d’URLs indésirables (avec paramètres d’URL par exemple) soient explorées et provoque une attention importante de Google sur des pages à faible valeur.

Et le remède ?

Il dépend bien sûr du problème déniché, mais ce rapport d’exploration de la Seach Console est souvent le point de départ de tests profonds.

Un niveau de découverte d’URLs anormalement élevé ? Un crawl Screaming Frog peut probablement me confirmer d’où ça vient. Un souci d’exploration du fichier robots.txt ? Il serait probablement bon de vérifier avec les développeurs si des changements récents ont eu lieu.

Que l’on soit à la recherche d’une optimisation de son budget de crawl ou de la source d’une chute drastique de son trafic, l’exploration est souvent un bon point de départ.

Bien évidemment les autres éléments (type de fichier, type de Googlebot), ont également leur importance mais constituent moins fréquement les premiers zones à étudier.

Il ne reste plus qu’à monitorer régulièrement cet espace crucial de la GSC et de prendre les mesures adéquates. Ne pas se gêner, c’est gratuit !

Vous avez des questions SEO ?

Partages X/Twitter du 14 au 20 octobre

Le saviez-tu ?

Si vous observez un nombre de demandes d'exploration en hausse dans la Search Console...

Cela peut indiquer un intérêt accru de la part de G, mais aussi des problèmes comme du contenu dupliqué et des espaces de crawl infini.

À surveiller de près !

Le niveau doit rester stable, hormis si vous avez créé du contenu supplémentaire.

Pour accéder au rapport :

Paramètres > Statistiques sur l'exploration

Merci à

@chicagoseopro

pour l'inspiration

Le saviez-tu ?

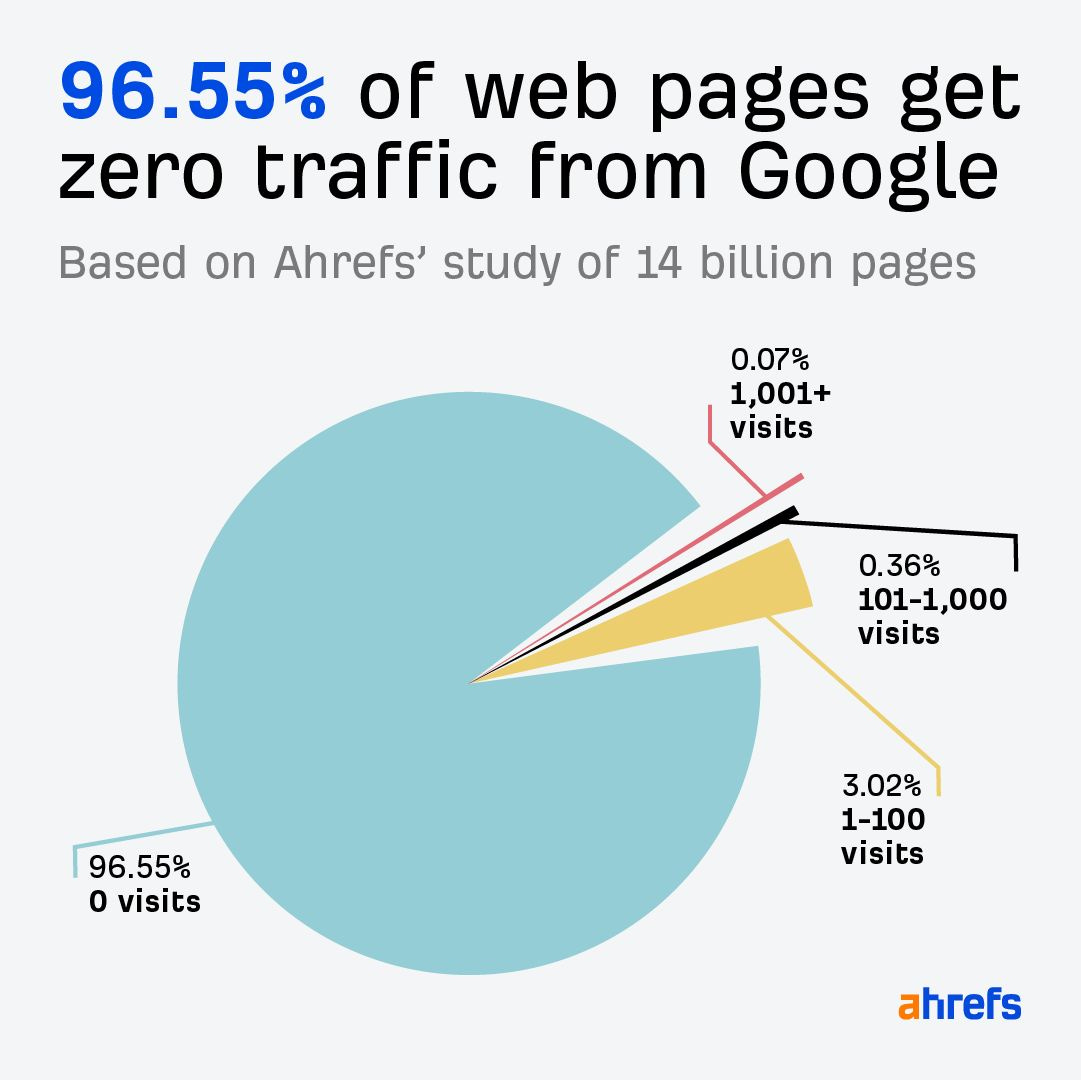

Près de 97% des pages Web n'obtiennent aucun trafic de la part de Google d'après une étude réalisée par @ahrefs.

🤯

Astuce du copain référenceur :

Si vous des difficultés à trouver des ressources pour régler un problème technique...

Mettez simplement en avant les €€€ perdus pour chaque mois où ce souci perdure.

Comment l'estimer ? 👇

1⃣ Si c'est une urgence et qu'une baisse soudaine a eu lieu, alors utiliser le pourcentage de différence avant/après est la voie à suivre

Par ex. : -18% de conversions organiques par rapport à la semaine dernière

Si la valeur moyenne d'une conversion en provenance du trafic organique est disons de 200€

200 x Y conversions perdues = Z €€€

2⃣ Si c'est une baisse progressive, alors une comparaison à l'année est souvent plus pertinente.

Par ex. : -7% de conversions organiques à l'année

Même calcul :

200 x Y conversions perdues = Z €€€

MAIS AUSSI

donner les pertes attendues l'année prochaine suivant les mêmes proportions si le souci n'est pas réglé

C'est une manière de déclencher une réaction rapide chez les décideurs.

Utiliser le coût PPC des mots-clés perdus que donnent des outils comme Semrush n'est en général pas la méthode à suivre.

En revanche, si ce sont les seuls chiffres à disposition, c'est tjrs mieux que rien.

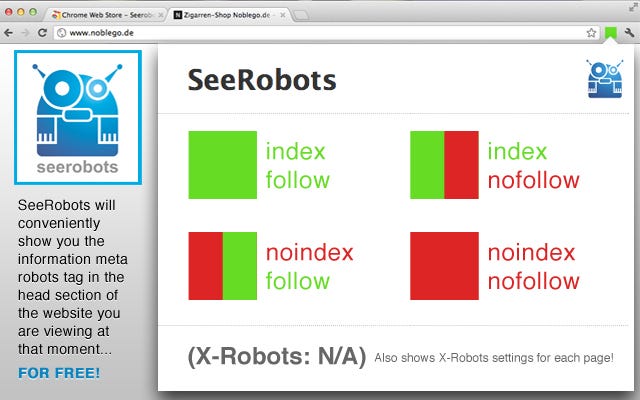

Pour ceux qui veulent savoir en deux secondes si une page est en noindex, nofollow :

L'extension Chrome gratuite SeeRobots le fait en couleur.

Un gros carré vert ? Index, follow

Un gros carré rouge ? Noindex, nofollow

Simple

Le saviez-tu ?

Trouver les balises Title courtes avec un outil comme Screaming Frog par exemple est un moyen rapide de dénicher des opportunités d'enrichissement en mots-clés.

Positionnement : 📈

MAIS !

Des Title courtes ont généralement un meilleur CTR.

Rappel amical :

Les Core Web Vitals sont un facteur de classement qui gagne en importance mais il n'est pas primordial.

Cad que si votre tactique consiste à principalement améliorer LCP, CLS, INP pour grimper les résultats de recherche, vous faites fausse route.