La profondeur de contenu est désormais la seule option

Vous avez des questions SEO ?

La facilité de création de contenu due entre autres à ChatGPT mène les moteurs à une véritable quête d’originalité et de profondeur. La différence avec l’ère pré-2023 ? Nous n’avons plus le choix. Voici ce que signifie véritablement créer du contenu en 2025.

Couverture du champ sémantique

La stratégie classique qui consiste à écrire une page dédiée pour chaque groupe de requêtes et liées de près ou de loin à l’activité principale du site a encore quelques beaux jours devant elle, mais plus pour longtemps.

La raison est simple : c’était il y a encore deux ans quelque chose de relativement compliqué à faire en raison des ressources humaines et temporelles nécessaires. L’expertise n’était pas toujours au rendez-vous mais les rédacteurs y apportaient une touche d’authenticité et d’originalité.

Aujourd’hui, pour peu que vous ayez Make, une clé d’API OpenAI et Airtable, vous pouvez entièrement automatiser la création de contenu et couvrir l’entièreté de votre domaine en l’espace de quelques heures. Et avec des informations et des tournures de phrase acceptables !

Beaucoup s’y adonnent et cela marche pendant un temps, jusqu’à la chute libre.

Le jeu n’en vaut pas…

Avec la quantité de textes d’IA publiés à la minute, Google est devenu efficace pour reconnaître les sites utilisant ces schémas de publication.

J’ai moi-même été coupable d’utiliser pareille technique par le passé, principalement pour tenter de garder un site actif malgré le manque de temps pour m’y consacrer. Avec le recul, le temps que j’ai passé à mettre le système au point aurait été mieux investi dans la création d’articles extrêmement creusés ou dans la recherche de rédacteurs auxquels j’aurais pu déléguer les besoins en écriture.

L’espace que Google accorde à un site entre son activité pure et dure et ce qu’il publie rétrécit de jour en jour, c’est à dire qu’il faut apprendre à devenir le meilleur sur un espace restreint et à maximiser les conversions sur ce trafic spécialisé.

La nouvelle échelle

Si se focaliser sur la qualité du contenu n’est pas nouveau, ce qui change, c’est l’échelle. Un contenu moyen pouvait parvenir à se hisser en page 1 pour peu que la compétition soit faible; ce n’est plus garanti aujourd’hui (mais encore possible).

Afin de parer à cela et focaliser ses efforts aux bons endroits, voici une liste d’actions à prendre dans cette nouvelle ère du référencement :

À choisir entre la création de 50 articles moyens et 1 article très creusé, priorisez ce dernier

La qualité de l’auteur et les informations disponibles (fiche auteur, profil LinkedIn) sont déterminantes, encore plus que par le passé

Surveillez les sujets des articles qui ont du mal à se positionner malgré un contenu de bonne facture puis…

…Créez des sites satellites sur des noms de domaine différents qui vont se focaliser à 100% sur le sujet ou sous-sujet. Ne les liez pas entre eux pour éviter de les catégoriser comme faisant partie d’un PBN (réseau de Blogs privés)

Prenez garde aux backlinks étrangers à forte autorité qui peuvent positionner votre contenu dans des résultats de recherche d’une langue qui n’est pas la langue cible, au détriment de cette dernière. Redirigez-les si nécessaire.

L’heure du changement

Les bases sont les mêmes, c’est-à-dire : qualité > quantité. En revanche le niveau de qualité requis, le périmètre à conquérir et la marge de manoeuvre sont de plus en plus compliqués.

Aujourd’hui plus que jamais, il faut commencer à pivoter afin de d’assurer des résultats à moyen et long termes.

Partages X/Threads du 10 au 16 février

Si vous l'avez manqué...

Google a mis à jour son rapport CrUX :

C'est ainsi qu'apparaissent les « LCP Subparts », qui indiquent les différents élements ayant un impact sur le chargement du LCP.

TTFB, Load Delay, etc

Le but : mieux comprendre les mauvaises perfs

Si ça vous semble être du charabia, voici un peu de documentation (en anglais):

Google : https://developer.chrome.com/blog/crux-2025-02

Debugbear : https://www.debugbear.com/blog/lcp-subparts

Un outil bien utile pour ceux qui prennent Core Web Vitals et performance technique au sérieux

Il s'agit de Calibre : calibreapp.com

Il inspecte les fichiers chargés sur une page de manière très minutieuse et inclus des alertes pour empêcher la régression

Il y a un essai gratuit mais c'est un outil payant.

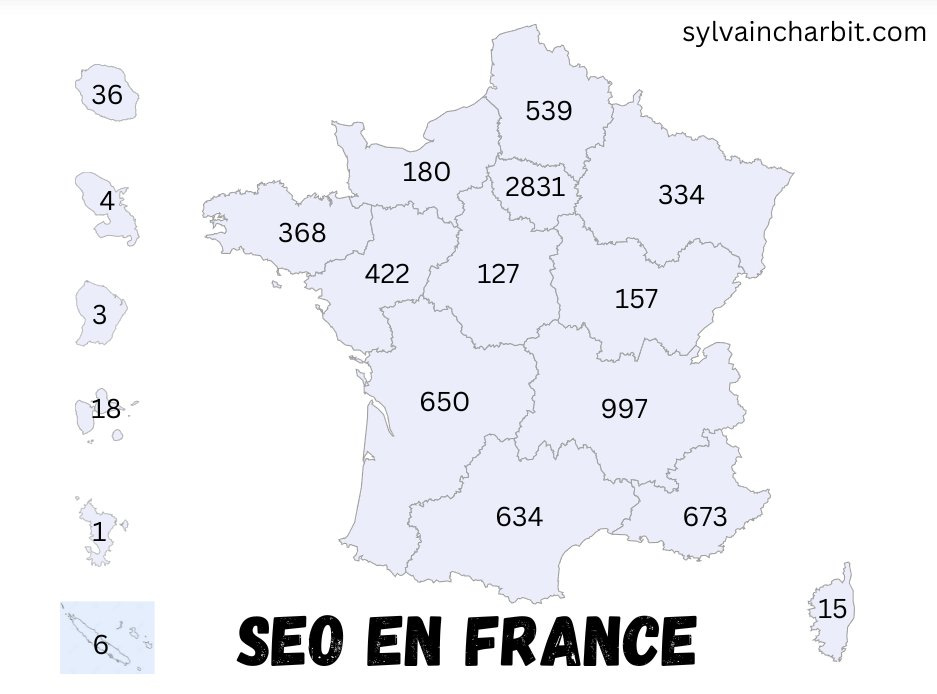

Carte avec le nombre de professionnels du SEO par région...

Obtenue après une recherche rapide de ceux qui ont « SEO » et « Référencement » dans leur intitulé de poste sur LinkedIn.

C'est imparfait ( 30%+ de ceux avec « référencement » n'ont pas de lien avec le SEO)

Les données :

France : 8157

Bretagne : 368

Normandie : 180

Hauts-de-France : 539

Grand-Est : 334

Île-de-France : 2831

Pays-de-la-Loire : 422

Centre-Val de Loire : 127

Bourgogne-Franche-Comté : 157

Nouvelle-Aquitaine : 650

Auvergne-Rhône-Alpes : 997

Occitanie : 634

Provence-Alpes-Côte d'Azur : 673

Corse : 15

La Réunion : 36

Martinique : 4

Guyane : 3

Guadeloupe : 18

Mayotte : 1

Nouvelle Calédonie : 6

D'autres postes avec par exemple « marketing » dans leur intitulé peuvent impliquer du travail de SEO, donc ces chiffres sont probablement en deçà de la réalité.

Si la recherche IA vous rend ronchon et vous préférez la sortir de votre vie

2 extensions Chrome gratuites :

Pre-AI Search qui montre les SERPs avant 2023

Hide Gemini qui cache tout ce qui a trait à l'IA de Google

Notez que je ne recommande PAS de les utiliser

Le saviez-tu ?

Google semble commencer à pénaliser sévèrement les images générées par IA.

Il s'agit potentiellement d'une MAJ visant à réduire drastiquement leur visibilité dans les résultats de recherche