Vous avez des questions SEO ?

Véritable fléau pour les sites imposants, la gestion du contenu dupliqué lié aux paramètres d’URL peut vite tourner au cauchemar, principalement lorsque d’autres équipes comptent dessus pour leur suivi de performances. Voici comment se sortir du pétrin et laisser champ libre au Googlebot :

Au commencement était le suivi et la recherche interne

Le plus simple pour prévenir de futurs maux de tête liés à un budget de crawl décimé par le contenu dupliqué est de se charger de ces problèmes dès le départ, c’est-à-dire à la création du site. Pourquoi ? Parce qu’une fois que Google découvre une URL, même dupliquée et sans valeur, il la garde en mémoire pour longtemps.

Donc la proactivité sur le sujet est de mise.

Maintenant, quels sont les principaux responsables de la génération de ce contenu dupliqué ? Les paramètres de suivi type UTM pour diverses campagnes ou pour tracer le comportement des utilisateurs sur le site; et les modules de recherche interne à grands coups de paramètres ?s= qui vont venir en rajouter.

Les premiers réflexes sont en général de placer un disallow sur ces mêmes paramètres dans le fichier robots.txt ou une balise canonique pointant ailleurs. Ce n’est malheureusement pas suffisant.

Supprime !

La première réponse est aussi simple que compliqué : il faut supprimer. Cela signifie que si vous avez des paramètres d’URL liés au traçage qui ne sont plus utilisés, il faut supprimer ces pages le plus possible. Problème : vous n’êtes souvent pas le seul à avoir votre mot à dire et trouver les équipes ayant généré ces paramètres relève souvent de la quête arthurienne.

Pour les modules de recherche, il faut « simplement » en changer, c’est à dire passer à un module qui va générer des pages de recherche interne n’ayant pas d’URLs propres. Pas vu, pas pris.

Les balises noindex sont utiles mais ne permettent pas de régler le problème entièrement.

L’art de la dissimulation

Enfin, lorsque supprimer le contenu dupliqué n’est pas possible, il reste la dissimulation. Le cloaking, malgré sa mauvaise presse, peut être largement toléré par Google et produire des effets (très) bénéfiques.

Pour cela, des techniques comme l’Edge SEO, qui va utiliser le CDN pour ne montrer aux Googlebots que les URLs que l’on désire, ou encore un script permettant de retarder l’ajout des paramètres d’URL sur la page (et d’éviter ainsi à Google de les voir), sont indiqués.

Retirer ou cacher

Deux options se présentent :

Retirer l’ensemble du contenu dupliqué inutilisé si les équipes sont d’accord

Cacher le reste aux yeux des moteurs

Et en attendant qu’une décision soit prise : canonique vers la page d’origine ou noindex si nécessaire (et non pas les deux, pour éviter d’envoyer un mauvais signal à la page de base).

À refaire tous les 1 à 2 ans pour éviter un effet d’accumulation qui va pénaliser le site à long terme.

Partages X/Twitter du 11 au 17 novembre

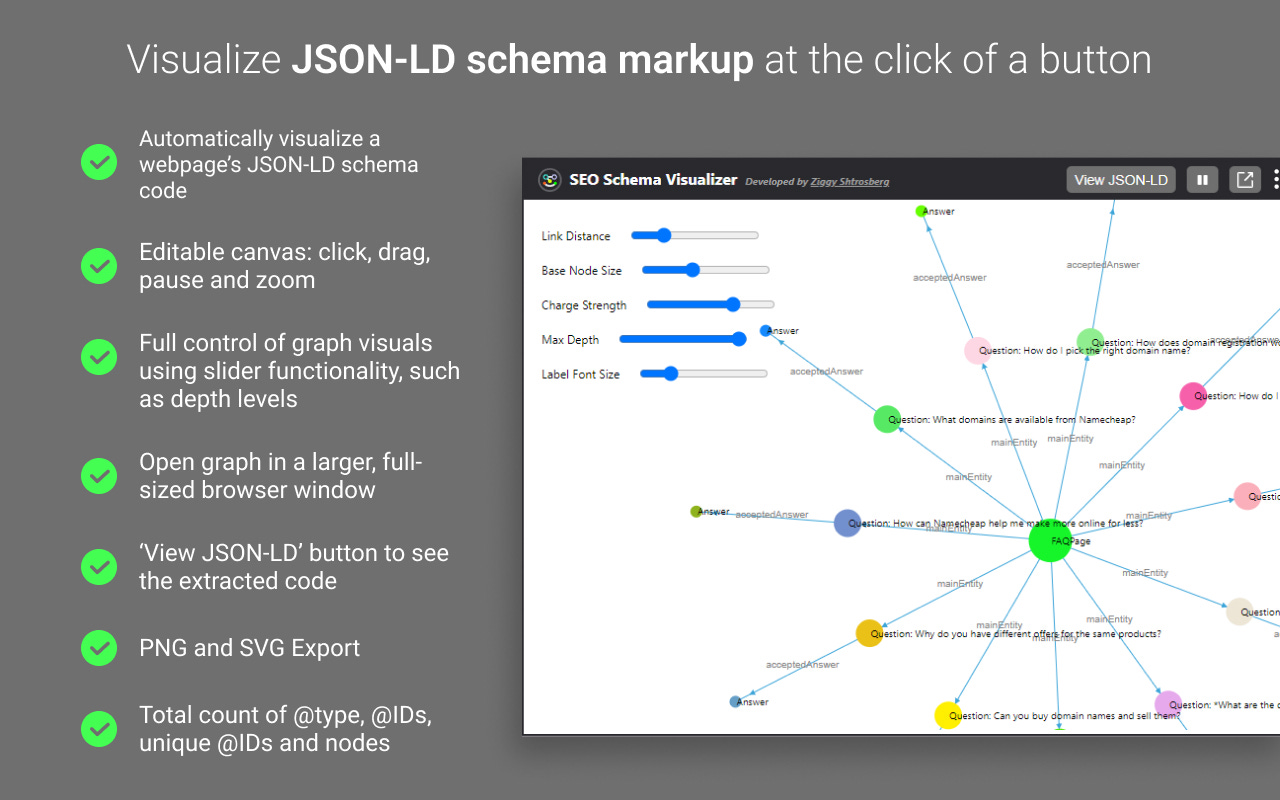

Difficile de cerner exactement toutes les subtilités de vos balises Schema ?

Essayez l'extension Chrome gratuite SEO Schema Visualizer.

Visualisez instantanément les connexions et détails de vos différents attributs.

Incroyablement utile

Rappel amical :

De nombreuses optimisations techniques ne sont pas évidentes à comprendre et encore moins à mettre en place pour les développeurs.

Demander à extraire le CSS critique par ex. et ne donner qu'un lien vers la doc Google est paresseux. À la place : 👇

1⃣ Effectuez des réunions régulières (même courtes <15mn) jusqu'à ce qu'elles deviennent inutiles.

2⃣ Créez des vidéos explicatives type Loom

3⃣ Rédigez de la documentation sur tous les détails de l'optimisation (y compris la doc Google), avec les personnes à contacter

Si cela semble être trop de travail pour une seule optimisation, alors :

- Vous avez trop de choses à faire et devriez déléguer/en enlever

- Cette optimisation n'est pas suffisamment importante et devrait être remise à plus tard

- Vous avez trop d'optis en cours, priorisez

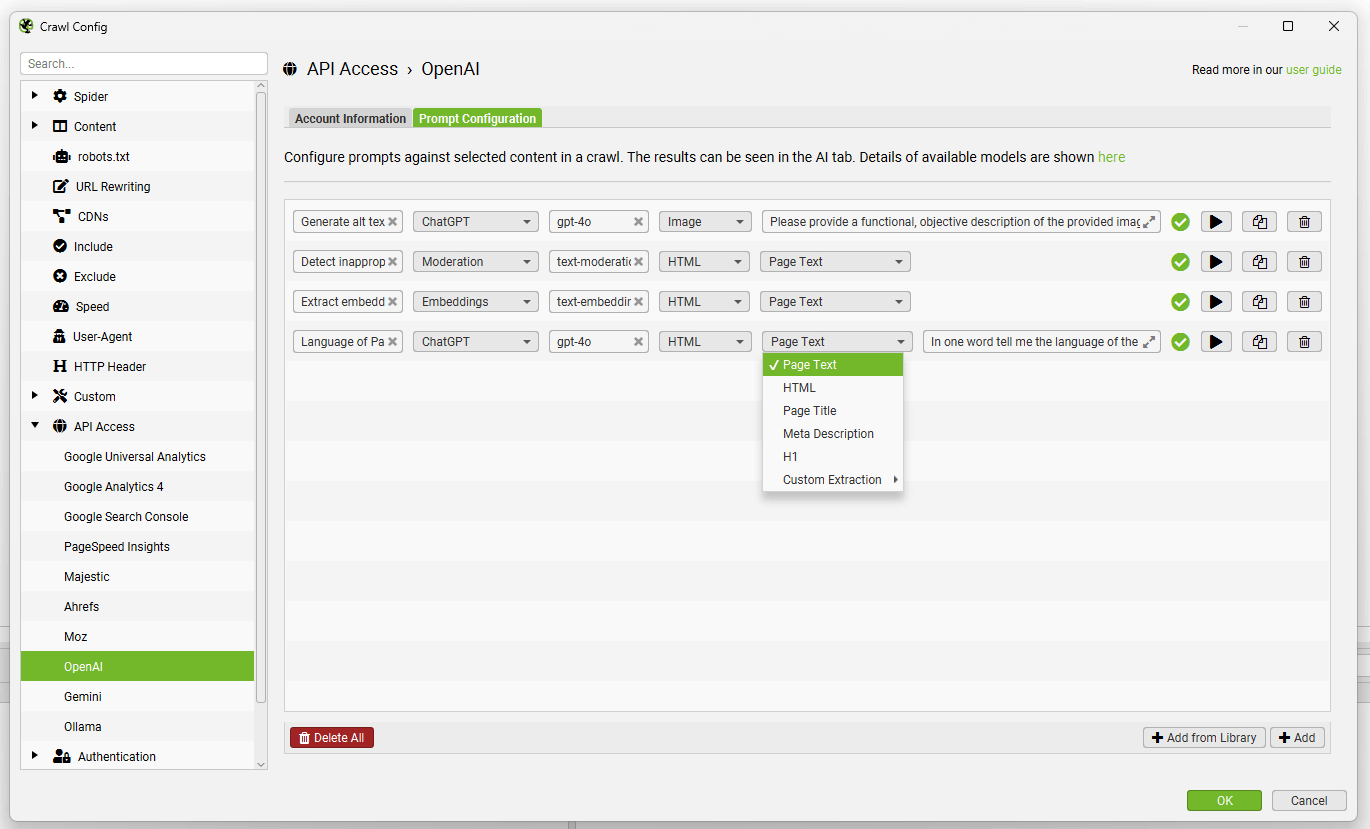

La version 21.0 de Screaming Frog est sortie !

La plus grosse MAJ est la connexion directe aux APIs d'OpenAI, Gemini et Ollama.

Vous ajoutez une commande pour l'IA qui se marie aux données de crawl, sans passer par des extraits JS.

Les avantages 👇

- N'ajouter sa clé d'API qu'une seule fois pour chaque plateforme d'IA

- Plus besoin de passer obligatoirement par le mode de rendu JavaScript. Tous les modes fonctionnent désormais.

- Plus besoin de modifier du code JS. Juste quelques clics et les instructions.

Les notes de mise à jour sont ici.

Citation du jour

Martin Splitt de Google rassure sur l'impact du contenu dupliqué :

« Certaines personnes pensent que cela influence la qualité perçue d’un site, mais ce n’est pas le cas. »

Cela peut en revanche allonger la durée de crawl nécessaire à grande échelle

La vidéo liée :

Rappel : les informations partagées par Google sont souvent à prendre avec des pincettes.

Les AI Overviews arrivent...

Dans plus de 100 nouveaux pays (mais toujours pas en France).

En revanche, si vous résidez aux Canada, vous pouvez d'ores et déjà les essayer (ce qui est surprenant, Google ne privilégie en général pas cette région).

Ce sera vite là.

La publication officielle à ce sujet.

Au cas où vous l'ayez manqué :

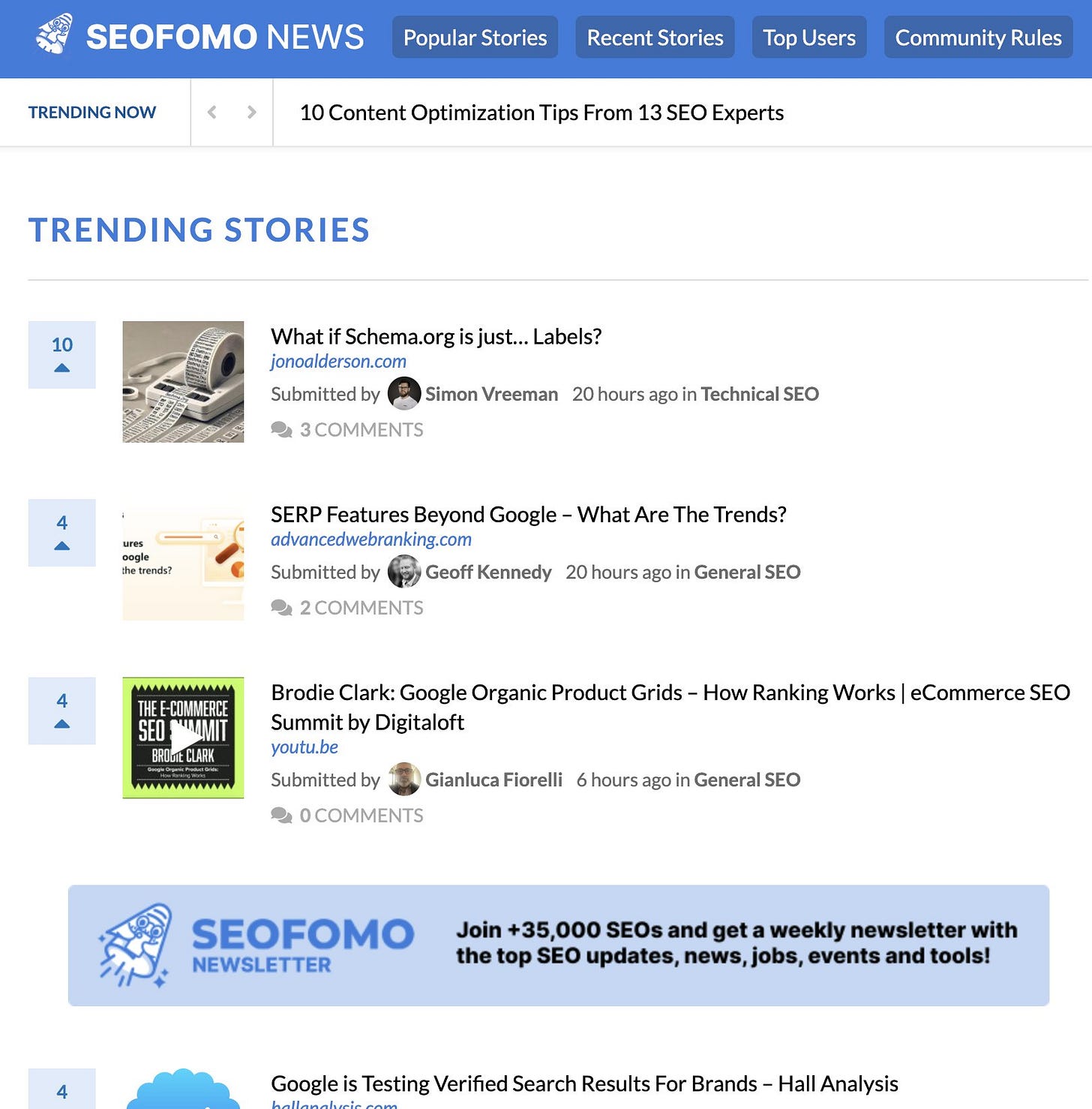

Aleyda Solis lance une nouvelle plateforme d'actus pour le SEO et le marketing digital en général : https://news.seofomo.co

Utile pour découvrir des articles de SEO technique (ou autre) qui diffèrent des sources habituelles.